Data Engineering (วิศวกรรมข้อมูล) เป็นกระบวนการในการออกแบบ พัฒนา จัดเก็บ และพัฒนาระบบประมวลผลข้อมูลเพื่อให้ธุรกินจำไปใช้ได้ ซึ่ง Data Engineer ผู้ที่ทำด้านนี้จะต้องนำเครื่องมือต่าง ๆ หลากหลายตัวมาประกอบกันเพื่อให้งานสำเร็จ

เมื่อเข้าใจเครื่องมือต่าง ๆ แล้ว จะทำให้เราเลือกใช้เครื่องมือได้ถูกต้อง เพื่อเตรียมข้อมูล และจัดเก็บข้อมูลอย่างเป็นระเบียบ เพื่อให้ผู้ใช้ (Data Scientist, Data Analyst, หรือหลายครั้งก็เป็นฝ่ายธุรกิจ) สามารถเข้าถึงได้ง่าย ซึ่งปลายทางของการทำงาน Data Science คือ การช่วยให้ผู้ใช้ได้รับข้อมูลเชิงลึกเกี่ยวกับธุรกิจหรืออุตสาหกรรมของตนมากขึ้น นั่นเองครับ

ด้วยความที่เทคโนโลยีมีให้เลือกใช้เยอะมาก สำหรับคนที่สนใจเริ่มต้นงานด้าน Data Engineer มักจะเจอปัญหาว่า “จะใช้เทคโนโลยีอะไรดี”

ในบทความนี้ เราจะมารู้จักกับ 7 เทคโนโลยีที่ Data Engineer ต้องรู้จักกัน อ่านจบแล้วคุณจะสามารถเลือกเทคโนโลยีที่เหมาะกับงานได้ดีขึ้น และถ้าไม่รู้จักเทคโนโลยีไหน เราก็จะแนะนำแหล่งเรียนต่อให้ตอนท้ายบทความนี้ด้วยครับ มาเริ่มกันเลย

1. ภาษาโปรแกรมมิ่ง เช่น Python, Go, Java, Scala

หนึ่งในสิ่งที่ Data Engineer ขาดไม่ได้เลย คือ ความรู้ในการเขียนโปรแกรม (Programming) ซึ่งในสายงาน Data ก็มีภาษาโปรแกรมมิ่งให้เลือกใช้มากมาย แล้วเราเลือกใช้ตัวไหนดี

1.1 Python ภาษาที่ทำงาน Data ได้ครอบจักรวาล

สำหรับผู้ที่ต้องการภาษาที่เขียนง่าย และสร้างผลลัพธ์ได้ทันที เช่น Data Scientist การเริ่มต้นด้วยภาษา Python เป็นเรื่องที่ดีครับ เนื่องจากว่าภาษา Python มีส่วนเสริมที่จำเป็นในการทำงานด้าน Data Engineering ครบมาก

นอกจากนั้นยังเอาไปทำงาน Data อื่น ๆ ได้อีกด้วย เช่น Machine Learning หรือแม้แต่การเอาไปทำความสะอาดข้อมูล (Data Wrangling) ครับ เรียกได้ว่าเรียนภาษาเดียวได้ครบหมดครับ

สำหรับท่านที่มาจากสาย Data Scientist หรือ Data Analyst อาจจะรู้จักภาษา R มาก่อนแล้ว การจะย้ายมาใช้ Python ไม่ยากเลยครับ สามารถอ่านเพิ่มเติมในบทความ Python vs R เพื่อให้รู้จักกับ Python มากขึ้น

1.2 Go ภาษาสำหรับผู้พัฒนาและดูแลระบบ

อีกหนึ่งภาษาที่กำลังได้รับความนิยมมากขึ้นเรื่อย ๆ โดยเฉพาะในสาย Platform Engineering (เป็นสายงานที่ใกล้เคียง Data Engineer แต่เน้นการพัฒนาและดูแลระบบจัดการข้อมูลเป็นหลัก) คือ ภาษา Go ซึ่งสร้างโดย Google

ข้อดีของภาษา Go คือ เน้นที่การทำงานที่รวดเร็ว ทำให้สร้างระบบจัดการข้อมูล (Infrastructure) ที่ทำงานได้มีประสิทธิภาพ

เครื่องมือที่นิยมด้าน Platform Engineering หลายตัวก็ถูกสร้างขึ้นด้วยภาษา Go เช่น Hashicorp Terraform

1.3 Java & Scala ภาษาสำหรับสาย On-premise

On-premise คือ การวางระบบไว้ในเซิร์ฟเวอร์ในบริษัท ซึ่งตรงข้ามกับการวางระบบไว้บนเซิร์ฟเวอร์ของ Cloud Computing ครับ พบได้บ่อยในองค์กรขนาดใหญ่ที่จำเป็นจะต้องจัดเก็บ Data ไว้ในระบบของตัวเอง

เทคโนโลยีสำหรับการทำงานกับข้อมูลแบบระบบ On-Premise ที่ได้รับความนิยม คือ Hadoop และส่วนประกอบต่าง ๆ ของระบบนี้ เช่น Apache Spark ก็จะถูกเขียนขึ้นด้วย Java และ Scala เพราะเป็นภาษาที่ทำงานได้รวดเร็ว

Scala เป็นภาษาที่มีลักษณะการเขียนพื้นฐานเป็น Java ทำให้ผู้ที่เขียน Java ได้อยู่แล้ว สามารถพัฒนาไปใช้ Scala ได้ครับ

เพราะฉะนั้น ความรู้ Java และ Scala จึงเหมาะมากกับผู้ที่ต้องการเขียนโปรแกรมจัดการข้อมูลบนระบบ On-Premise

หากคุณอยากรู้เพิ่มเติมเกี่ยวกับภาษาโปรแกรมมิ่งในการทำงานด้าน Data ทั้งหมด สามารถอ่านได้ในบทความ 7 ภาษาโปรแกรมมิ่งที่ Data Scientist ต้องรู้

นอกจากภาษาโปรแกรมมิ่งแล้ว สิ่งที่ขาดไม่ได้สำหรับงาน Data Engineer คือ “ระบบจัดเก็บข้อมูล” เรามารู้จักระบบเหล่านี้กันครับ

2. Database: ฐานข้อมูลแบบ SQL และฐานข้อมูล NoSQL

ระบบเก็บข้อมูลที่ได้รับความนิยมมากที่สุด ถ้าไม่นับการเก็บในไฟล์ Excel ที่ข้อมูลกระจัดกระจาย และยังจัดการข้อมูลได้ไม่ดีเท่ากับภาษาโปรแกรมมิ่งแล้ว ก็หนีไม่พ้น Database หรือ ระบบฐานข้อมูล ครับ

Database คือ ระบบจัดเก็บข้อมูลที่สามารถรองรับข้อมูลได้จำนวนมากในระดับหนึ่ง ซึ่งข้อมูลในฐานข้อมูลมีข้อดีที่สามารถทำงานกับข้อมูลได้ง่าย และค้นหาข้อมูลได้ง่าย

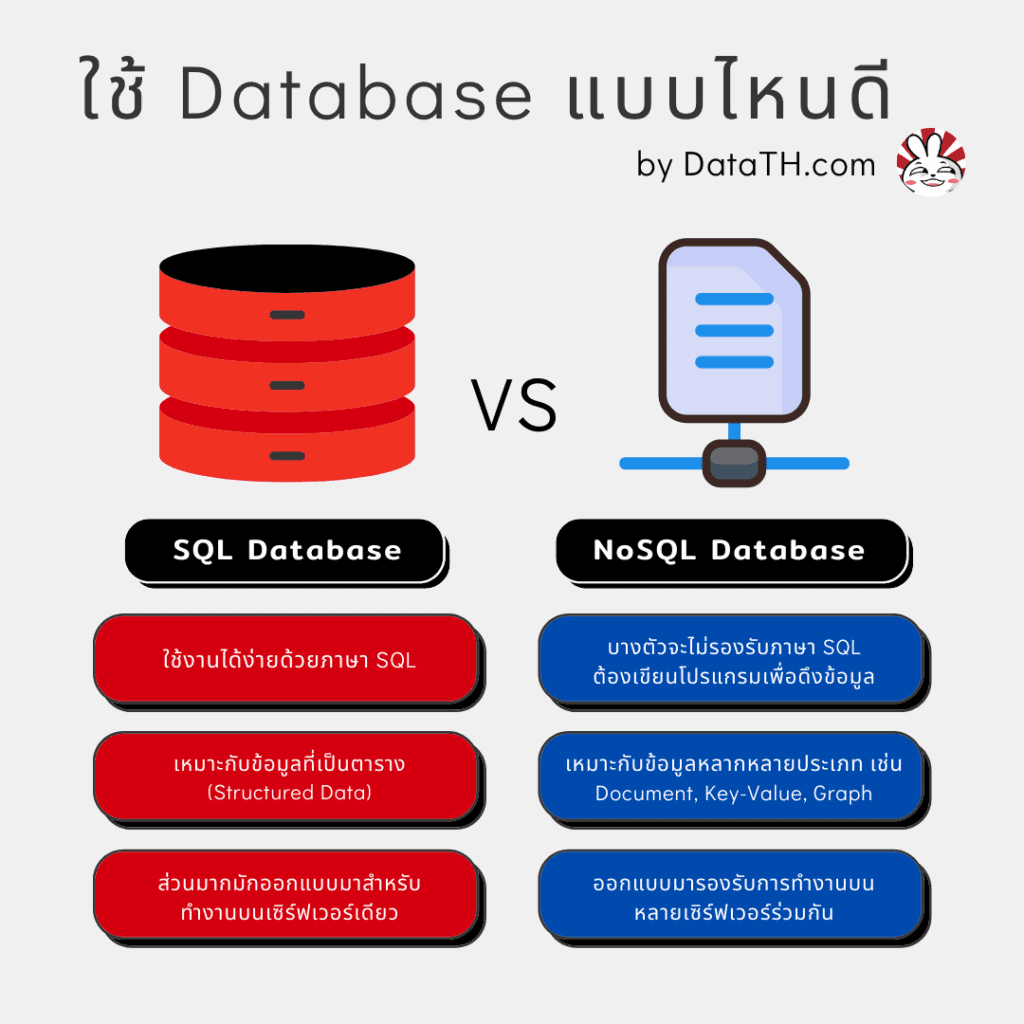

ฐานข้อมูล 2 ประเภทหลัก: ฐานข้อมูลแบบ SQL และแบบ NoSQL

SQL เป็นภาษาในการดึงข้อมูลมาใช้งานที่มีชื่อเต็ม ๆ ว่า Structured Query Language ซึ่งเหมาะกับการดึงข้อมูลจากฐานข้อมูลที่เป็นตาราง หรือ Structured Data และหากคุณยังไม่เคยใช้ฐานข้อมูลมาก่อน มันจะเหมือนกับการจัดเก็บข้อมูลใส่ตารางแบบ Excel หรือ Google Sheets ครับ

ฐานข้อมูลอีกแบบหนึ่งที่ได้รับความนิยมมากขึ้นเรื่อย ๆ ในการทำเว็บไซต์ หรือแอพพลิเคชั่น คือ NoSQL เนื่องจากการเก็บข้อมูลมีความยืดหยุ่นกว่า และมีให้เลือกใช้หลายแบบ เช่น ฐานข้อมูลสำหรับจัดเก็บข้อมูลแบบเป็นเอกสาร (Document Database) หรือ ฐานข้อมูลที่จัดเก็บข้อมูลเป็นกราฟ (Graph Database)

อย่างไรก็ตาม ในฐานะของ Data Engineer เราจะไม่ได้มีโอกาสได้ทำงานกับ Database แบบใกล้ชิดมากครับ โฟกัสของงาน Data Engineer จะอยู่ที่เทคโนโลยีในการจัดเก็บข้อมูลข้อต่อไปครับ

ถ้าอยากรู้เกี่ยวกับ Database เพิ่มเติม แนะนำให้อ่านบทความ Big Data เก็บที่ไหน ครับผม

3. Data Warehouse: คลังข้อมูล ระบบเก็บข้อมูลสำหรับการวิเคราะห์

Data Warehouse หรือ คลังข้อมูล คือ ระบบเก็บข้อมูลขนาดใหญ่ที่ถูกสร้างขึ้นมาเพื่อใช้สำหรับการวิเคราะห์ข้อมูลโดยเฉพาะ

Data Warehouse กับ Database แบบ SQL มีความคล้ายคลึงกันมาก มักจะจัดเก็บข้อมูลเป็นตารางเหมือนกัน และสามารถดึงข้อมูลได้ด้วยภาษา SQL เหมือนกัน

แปลว่า Data Warehouse ก็คือ Database ที่ขนาดใหญ่ขึ้นเท่านั้นหรือเปล่า ?

ข้อแตกต่างสำคัญ ระหว่าง Database และ Data Warehouse คือ “จุดประสงค์การใช้งานที่แตกต่างกัน”

Database ส่วนใหญ่จะถูกสร้างขึ้นมาเพื่อใช้งานร่วมกับระบบเว็บไซต์ หรือ แอพพลิเคชั่น เน้นหนักที่จะทำให้การเขียนข้อมูลทำได้รวดเร็ว เนื่องจากระบบเว็บไซต์ หรือแอพพลิเคชั่น มีผู้ใช้งานที่ต้องการการเขียนข้อมูลจำนวนมากพร้อม ๆ กัน

ลองนึกถึงระบบขายสินค้าออนไลน์ (E-Commerce) ก็ได้ครับ ในการจัดโปรโมชั่นวันที่ 8.8 ก็จะมีคนเข้ามาซื้อสินค้าพร้อมกันอย่างถล่มทลาย และทุกคนก็ต้องการเขียนข้อมูล (สั่งสินค้า) พร้อม ๆ กัน ทำให้ Database ต้องรองรับการเขียนข้อมูลได้อย่างรวดเร็ว

ในทางกลับกัน Data Warehouse ไม่ได้ถูกสร้างขึ้นมาเพื่อให้เขียนข้อมูลได้อย่างรวดเร็ว แต่ Data Warehouse ให้ความสำคัญกับการอ่านข้อมูลได้อย่างรวดเร็วมากกว่า เพื่อให้คนที่ต้องการข้อมูล ไม่ว่าจะเป็น Data Scientist, Data Analyst, หรือแม้แต่ฝ่ายธุรกิจ สามารถดึงข้อมูลที่ต้องการไปใช้ได้

เพราะฉะนั้น Data Warehouse จึงถือเป็นเครื่องมือที่ Data Engineer ไม่ว่าจะอยู่ในองค์กรเล็กหรือใหญ่ จะมีโอกาสได้ใช้งานเยอะมากครับ เช่น ในการทำ ETL

4. Data Lake: ระบบเก็บไฟล์ข้อมูล สำหรับรอการนำไปใช้ต่อ

Data Lake ถือเป็นศัพท์ใหม่ที่เกิดขึ้นมาในยุค Big Data ครับ เนื่องจากว่าในยุคนี้เรามีไฟล์ข้อมูลหลากหลายรูปแบบ ไม่ว่าจะเป็นไฟล์รูป เสียง วีดิโอ ฯลฯ จะเอาไปเก็บไว้ใน Database หรือ Data Warehouse ก็ไม่เหมาะ

Data Lake ดูเผิน ๆ จะเหมือนกับ Harddrive เก็บไฟล์ทั่ว ๆ ไปครับ ลองนึกถึง Dropbox หรือ Google Drive

สิ่งที่ทำให้ Data Lake แตกต่างจากสถานที่เก็บข้อมูลส่วนตัว จะเป็นเรื่องของ

- Large Storage – พื้นที่เก็บไฟล์เยอะมาก และในหลายระบบ (เช่น Cloud Computing) ก็เพิ่มพื้นที่ได้แทบจะไม่จำกัดเลยครับ

- Fault-Tolerant – ความทนทาน เซิร์ฟเวอร์ล่มไฟล์ก็ไม่หาย เพราะไฟล์เก็บไว้หลายที่โดยอัตโนมัติ

- Governance – ควบคุมการเข้าถึงของแต่ละไฟล์ได้

- API Access – เข้าถึงไฟล์ผ่านการเขียนโปรแกรมได้ ทำให้เชื่อมกับระบบต่าง ๆ ในการจัดการ Data ได้ดี

ด้วยความที่ Data Lake ทำให้บริษัทจัดการ Big Data ได้สะดวกมากยิ่งขึ้น ทำให้ทุกโปรเจค Big Data จะต้องมีการใช้ Data Lake ครับ เป็นเครื่องมือที่เรียนรู้ได้ง่าย ที่อาชีพ Data Engineer ต้องรู้จัก

เทคโนโลยีสำหรับสร้าง Data Lake ในปัจจุบันก็มีหลายตัวเลยครับ ถ้าท่านใดสนใจเรื่องนี้ เรามีเขียนเล่าให้ฟังกันในบทความก่อนหน้านี้ พร้อมวิธีการเลือกใช้ที่เก็บข้อมูล ระหว่าง Database vs Data Warehouse vs Data Lake ใช้ตัวไหนดี และทำกราฟฟิกอธิบายแบบเข้าใจง่ายมาก

สามารถอ่านเพิ่มเติมเรื่อง Data Lake ได้ที่บทความ เปรียบเทียบความแตกต่างระหว่าง Database vs Data Warehouse vs Data Lake เลยครับ

5. Apache Spark ระบบประมวลผลข้อมูลขนาดใหญ่แบบเร็วจี๋

หลังจากที่เราพูดถึงเทคโนโลยีในการจัดเก็บ Big Data กันแล้ว เรามาดูเทคโนโลยีในการประมวลผล Big Data กันบ้างดีกว่าครับ

Apache Spark เป็นเทคโนโลยีการประมวลผลข้อมูลที่รองรับการทำงานร่วมกันของคอมพิวเตอร์หลายตัว (Distributed Computing) ที่เปิดให้คนทั่วไปเข้ามาใช้และแก้ไขต่อเติมได้อย่างอิสระ (Open Source)

Apache Spark เกิดขึ้นในปี 2009 โดยแล็บที่ UC Berkeley มหาวิทยาลัยชื่อดังในอเมริกา และในปัจจุบันผู้สร้าง Apache Spark ก็ออกมาเปิดเป็นบริการ Data Platform ชื่อ Databricks ซึ่งทำงานบนระบบ Apache Spark

ปัจจุบัน Apache Spark ถือนำไปใช้ในบริษัทใหญ่ ๆ อย่างแพร่หลาย เช่น Amazon, Intel, Target ฯลฯ เนื่องจากตัว Apache Spark ทำให้บริษัทสามารถประมวลผลข้อมูลขนาดใหญ่ได้อย่างรวดเร็ว

Apache Spark จึงเป็นเครื่องมืออีกตัวหนึ่งที่สำคัญสำหรับอาชีพ Data Engineer อย่างมากเลยครับ

สำหรับท่านที่อยากรู้จัก Apache Spark เพิ่มเติม และอยากรู้ข้อแตกต่างระหว่าง Apache Spark กับเทคโนโลยีที่คุณอาจจะเคยได้ยินมา อย่าง Hadoop MapReduce สามารถอ่านได้ที่บทความ Apache Spark คืออะไร เรามีอธิบายไว้ครบเลยครับ

นอกจากนั้น สำหรับผู้ที่สนใจเริ่มใช้ Apache Spark อยากจะแนะนำให้ลองใช้ PySpark ซึ่งเป็นระบบของ Apache Spark ที่เชื่อมต่อกับ Python ครับ ข้อดี คือ สามารถเขียนได้ง่าย และประมวลผลข้อมูลได้เร็วมาก ๆ

โดยเฉพาะอย่างยิ่ง ถ้าใครใช้ Pandas จัดการข้อมูลขนาดใหญ่อยู่ แล้วเจอปัญหาว่า Pandas ทำงานช้า การใช้ PySpark จะตอบโจทย์มากครับ

6. Apache Airflow เครื่องมือทำ Data Pipeline ที่บริษัทใหญ่ ๆ เลือกใช้

เราได้รู้จักกับเทคโนโลยีในการเก็บข้อมูล และประมวลผลข้อมูลกันไปแล้ว แต่สิ่งที่ขาดไป คือ เครื่องมือในการจัดการให้เทคโนโลยีเหล่านั้นสามารถทำงานร่วมกันได้ เราเรียกเครื่องมือกลุ่มนี้ว่า Data Pipeline Orchestrator

เครื่องมือด้าน Data Pipeline Orchestrator มีหลายตัวเลยครับ ตัวที่มีชื่อเสียงมากที่สุดตัวหนึ่ง คือ Apache Airflow ซึ่งเป็นระบบที่เปิดให้คนทั่วไปเข้ามาใช้งาน และแก้ไขได้อย่างอิสระ

Apache Airflow เกิดขึ้นจากปัญหาการจัดการการประมวลผลข้อมูลจำนวนมากที่ AirBnb ในปี 2014 ทำให้ทีม Data Engineer ในขณะนั้นลงมือสร้างเครื่องมือจัดการ Data Pipeline ของตัวเองขึ้นมา

จุดเด่นของ Apache Airflow คือ ระบบทั้งหมดถูกเขียนด้วยภาษา Python และผู้ใช้ระบบนี้ก็สามารถเขียน Data Pipeline ด้วยภาษา Python ได้เลย ไม่ต้องเรียนภาษาใหม่

ซึ่งอย่างที่เล่าให้ฟังก่อนหน้านี้ว่า Python เป็นภาษาที่เริ่มต้นเรียนรู้ได้ง่าย และเป็นภาษาที่ได้รับความนิยมมากในการทำงานกับ Data ทำให้มีบริษัทใหญ่มาใช้ Apache Airflow กันเยอะมากครับ

สำหรับสาย Data Engineer เราต้องรู้จักเครื่องมือในการทำ Data Pipeline Orchestration ครับ ซึ่ง Apache Airflow ก็เป็นจุดเริ่มต้นที่ดีเลย และต่อให้บริษัทไปใช้เครื่องมือตัวอื่น เราก็จะได้เรียนรู้คอนเซปต์ของการสร้าง Data Pipeline เช่น การทำ Directed Acyclic Graph (DAG) ทำให้ต่อยอดได้ง่ายครับ

7. Cloud Computing เทคโนโลยีที่อยู่เบื้องหลังระบบ Big Data ทั่วโลก

มาถึงเทคโนโลยีสุดท้ายที่ถือได้ว่าเป็นเทคโนโลยีที่เข้ามาเปลี่ยนโลกของ Data Engineer เลยครับ

Cloud Computing คือ การที่บริษัทใหญ่ ๆ เช่น Amazon, Google, Microsoft ลงทุนกับการสร้างอาคารจัดเก็บคอมพิวเตอร์ และจ้างคนมาดูแล (เรียกว่า Data Center) ซึ่งใช้เงินเป็นร้อยล้านพันล้าน แบ่งเซิร์ฟเวอร์ของตัวเองออกมาเป็นบริการเช่าให้กับบริษัทอื่น ๆ ครับ

สาเหตุที่ Cloud Computing เข้ามาเปลี่ยนโลกของ Data Engineer ก็เพราะว่า จากเดิมบริษัทที่ต้องการทำงานร่วมกับ Big Data จะต้องลงทุนเองทั้งหมดในการสร้าง Data Center ของตัวเองขึ้นมา พอมี Cloud Computing ก็สามารถไปจ่ายเงินเพื่อเช่าใช้งานจากบริษัทใหญ่ ๆ ที่มี Data Center อยู่แล้วได้ ประหยัดไปได้เยอะมาก

การจ่ายเงินของ Cloud Computing เราจะเรียกว่า “Pay-as-you-go” ครับ คล้ายกับระบบมือถือเติมเงิน ที่พอโทร 1 ครั้ง หรือส่ง SMS 1 ครั้งก็จะคิดเงินเรา และถ้าไม่โทรเลย ก็ไม่คิดเงินเลยครับ

แต่ใน Cloud Computing เราไม่ต้องจ่ายเงินก่อน รอบิลตอนปลายเดือนทีเดียวเลย (แต่ระหว่างนั้นก็จะสามารถดูได้นะครับว่าเราใช้ไปเท่าไหร่แล้ว)

นอกจากนั้น บริการ Cloud Computing เจ้าใหญ่ ๆ ก็จะมาพร้อมกับบริการที่ไม่สามารถหาระบบ Open Source อื่น ๆ มาแทนได้ เช่น Google มีบริการ Google BigQuery ซึ่งเป็น Data Warehouse ความเร็วสูง ที่มีให้บริการเฉพาะบนระบบ Cloud Computing ของ Google เท่านั้นครับ

และสำหรับท่านใดสนใจด้านการทำ Deep Learning, Machine Learning การเลือกใช้ Cloud Computing ก็เป็นทางเลือกที่ดีครับ เพราะ มีบริการ Machine Learning บน Cloud ให้เลือกมากมาย และหลายบริการไม่ต้องเขียนโค้ดเยอะก็สามารถสร้าง Machine Learning Model ของตัวเองขึ้นมาได้ครับ เช่น บริการ AutoML

แนะนำคอร์สสำหรับเรียนสกิล Data Engineer เหล่านี้

สำหรับท่านที่สนใจเรียนรู้สกิลและเทคโนโลยีต่าง ๆ ที่จำเป็นสำหรับ Data Engineer สามารถเลือกดูคอร์สเหล่านี้ได้เลยครับ เราจะพยายามเลือกคอร์สจาก Udemy มานำเสนอ เนื่องจากมีโปรโมชั่นบ่อยครับ คอร์สนึงไม่แพง แต่เนื้อหาคุ้มมาก

| ชื่อคอร์ส | รายละเอียด | ลิงค์ |

|---|---|---|

Python Programming for Beginners in Data Science |

| ดูคอร์สนี้ |

SQL, NoSQL, Big Data and Hadoop |

| ดูคอร์สนี้ |

Data Warehouse Fundamentals for Beginners |

| ดูคอร์สนี้ |

Data Engineering using Databricks on AWS and Azure |

| ดูคอร์สนี้ |

The Complete Hands-On Introduction to Apache Airflow |

| ดูคอร์สนี้ |

Introduction to Cloud Computing on Amazon AWS for Beginners |

| ดูคอร์สนี้ |

สรุป เทคโนโลยีสำหรับ Data Engineer ที่ควรรู้

ในบทความนี้ เราก็ได้รู้จักกับเทคโนโลยีต่าง ๆ ที่ Data Engineer (วิศวกรข้อมูล) ทุกคนต้องรู้จัก ได้แก่

- Python, Java ภาษาโปรแกรมมิ่ง

- Database ฐานข้อมูล

- Data Warehouse คลังข้อมูล

- Data Lake ระบบเก็บไฟล์ข้อมูล

- Apache Spark ระบบประมวลผลข้อมูลขนาดใหญ่

- Apache Airflow เครื่องมือ Data Pipeline

- Cloud Computing ระบบจัดการ Big Data

ถ้าตอนนี้ยังไม่รู้จักตัวไหนก็ไม่เป็นไรครับ สามารถเรียนรู้เพิ่มเติมได้เลยจากคอร์สที่เราแนะนำไว้ด้านบนแล้วครับ

และสำหรับคนที่เพิ่งเริ่มต้น ไม่รู้ว่าจะศึกษาจากไหนดี ส่วนตัวขอแนะนำให้เริ่มที่ข้อ 1 การเขียนโปรแกรมก่อนเลยครับ เพราะถือเป็นพื้นฐานที่ได้นำมาใช้กับอีก 6 ข้อที่เหลือได้สบายเลยครับ

ส่วนถ้าใครคิดว่าบทความนี้มีประโยชน์ อยากฝากให้ช่วยแชร์ให้เพื่อน ๆ หน่อยนะครับ และถ้าอยากติดตามบทความดี ๆ ด้าน Data กันบน Facebook หรืออยากมาพูดคุย ติชมกัน เชิญได้ที่ Facebook Page: DataTH – Data Science ชิลชิล ได้ตลอดเลยคร้าบ